一支烟花官网:

https://agifun.love

智源社区

我是如何赢得GPT-4提示工程大赛冠军的

Datawhale干货作者:Sheila Teo,来源:机器之心去年 11 月 8 日,新加坡政府科技局(GovTech)组织举办了首届 GPT-4 提示工程(Prompt Engineering)竞赛。数据科学家 Sheila Teo 最终夺冠,成为最终的提示女王(Prompt Queen)。之后,Teo 发布了一篇题为《我如何赢得了新加坡 GPT-4 提示工程赛》的博客文章,慷慨分享了其获胜法门。机器之心对这篇文章进行了不改变原义的翻译与整理,以帮助我们的读者同样成为 LLM 提示工程达人。以下是博客原文内容。上个月,我非常荣幸地赢得了新加坡首届 GPT-4 提示工...

来源:http://mp.weixin.qq.com/s?__biz=MzIyNjM2MzQyNg==&mid=2247665816&idx=1&sn=7e535a890e69817023069b045193e19b&chksm=e977fef79bf68db85a0fce7a263e4d0667c998e95895e4a9356a738c02424629d24ae09c47c1&scene=0&xtrack=1#rd

ComfyUI DynamiCrafter教程|颠覆AI视频生成!分分钟实现图转视频,细节也能完美调整

近日,由北大、腾讯 AI Lab 联合推出的 AI 视频生成工具 DynamiCrafter 一经上线便引起了巨大反响。只需要输入一张普普通通的静态图,加上几句简单的文字引导,瞬间就能生成超逼真的动态视频!

静态图+fireworks display=过程动态图

上篇教程小编已经带大家体验了一把 DynamiCrafter 的 WebUI 版使用方法,该方法简单易用,小白也能分分钟上手,但想要更细致地调整局部细节,WebUI 就有点局限了。

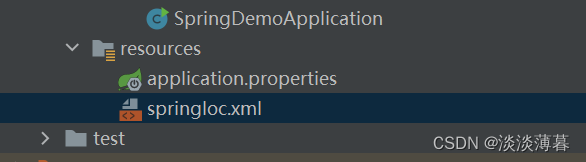

相较而言,ComfyUI 基于节点式的界面和工作...

来源:

13岁学编程、16岁开公司的天才少年,专访Hinton:AI教父的心路历程!

Datawhale干货访谈:AI教父Hinton,来源:新智元【导读】从谷歌离职一年之际,「人工智能教父」Hinton接受了采访。半退休的Hinton向我们讲述了时光积累下来的智慧,以及那些年和徒弟Ilya在一起的日子。从谷歌离职一年之际,「人工智能教父」Hinton接受了采访。视频地址:https://www.youtube.com/watch?v=tP-4njhyGvo当然了,采访教父的小伙子也非等闲之辈,Joel Hellermark创立的Sana已经融资超过8000万美元,他本人也曾因为在推进AI方面的工作,而入选福布斯30 under 30(30位30岁以下精...

来源:http://mp.weixin.qq.com/s?__biz=MzIyNjM2MzQyNg==&mid=2247665804&idx=1&sn=9e59023134ab3144c774f3d4ef5fe09d&chksm=e924f1082574db240c6b4054cd801c0b07d9ec223b5e596dd3010f7a8191ab901c1824f1bf8a&scene=0&xtrack=1#rd

Lectures by the IBM Delegation: Ethics in the Age of AI

Lectures by the IBM Delegation:Ethics in the Age of AIIBM代表团来访及讲座活动:人工智能时代的伦理人工智能技术的快速发展,在给人类社会带来潜在巨大发展红利的同时,其不确定性可能带来许多全球性挑战,甚至引发根本性的伦理关切。如何在“以人为本”和“智能向善”理念指引下,增进各界对人工智能伦理问题的理解,确保人工智能安全、可靠、可控,更好赋能全球可持续发展,增进全人类共同福祉?6月5日下午,IBM全球首席合规官Hans Vad Hansen先生以及IBM副总裁、大中华区首席技术官谢东先生将携团队到访清华大学公共管理学院(公管学院),...

来源:http://mp.weixin.qq.com/s?__biz=MzU4MzYxOTIwOQ==&mid=2247510211&idx=1&sn=36b4c9a79bba3163aa724c22d363381d&chksm=fc2c06b2ce616786b45e77e273ef9b7287818afc2a18764f7592a4095b4dfc346640afd4f076&scene=0&xtrack=1#rd

【AI治理周报-6月第1周】G7讨论建立机制,在军事领域推进负责任地开发与使用人工智能;法国是欧洲人工智能领域的领先者

点击蓝字关注我们AI治理周报01【本周头条】七国集团(G7)讨论建立机制,在军事领域推进负责任地开发与使用人工智能02【人工智能动态】2024中国数字经济发展与法治建设论坛聚焦人工智能技术发展与法律应对03【政府动态】由于人工智能带来的电力需求激增,美国放缓淘汰燃煤电厂的计划04【政府动态】法国借力美国科技巨头、目标成为全球人工智能超级大国05【AI巨头动态】英伟达CEO黄仁勋表示,由英伟达芯片和软件驱动的机器人时代和“AI 工厂”即将到来06【AI巨头动态】英特尔、谷歌和其他科技巨头联手开发UALink AI芯片互连技术07【AI巨头动态】微软将向云计算行业组织支付费用以终止欧盟...

来源:http://mp.weixin.qq.com/s?__biz=MzU4MzYxOTIwOQ==&mid=2247510211&idx=2&sn=c5b75cd087201a0a314ff3c51c316501&chksm=fc71450dc9acb7a8175a30b5f6315661ffecb8bee5736e408bedb8f535632153b4a0560be8a6&scene=0&xtrack=1#rd

InfoQ

关于Vearch在大模型中使用的一些实践

本文主要介绍了京东自研向量库Vearch的基本使用,借助我们在大模型RAG应用中的实践,介绍了它的两个核心能力:存储及检索,同时对实践中遇到的一些问题,也给出了解决方案。另外本文也对大模型中的部分常识也做了基本介绍,希望对大家有所帮助。

来源:https://www.infoq.cn/article/695b4d28832c9e551efa7cc6c

什么是LLM大模型训练,详解Transformer结构模型

本文介绍了大模型训练、推理的基本逻辑,并以Transformer为例,分析了其特点和优势。

来源:https://www.infoq.cn/article/c965120d46e5bc4d5d790d1a7

AI辅助内部研发效率提升,昇腾大模型推理的最佳实践

本文整理自华为昇腾计算首席架构师王建辉在 AICon 2024 北京的演讲。

来源:https://www.infoq.cn/article/C9vjic1Oj9JhyHY3m645

大模型加持下的 AIOps 业务场景实践有哪些新“解法”?

期待大模型能优化 AIOps 在数据理解、关联和交互体验上的表现。

来源:https://www.infoq.cn/article/AsEk7t1aSPEKHSQatxGa

一边增长一边裁员!微软大刀挥向Azure云及混合现实部门,上千人业绩好也逃不掉被裁?

整理 | 华卫 继2023年初裁员 1 万多人、今年 1 月在动视暴雪和 Xbox 部门裁员1900人之后,微软再次在三个部门裁员数百人。

来源:https://www.infoq.cn/article/NzBxv0DhW6tau3LyhbW3

ShowMeAI社区

打造AI爆款应用<新>黄金法则;盘点20款最流行AI搜索工具;ChatGPT对在线知识社区的影响;100万用户教会我的5个教训 | ShowMeAI日报

-

盘点 20 款最流行的AI搜索应用,你最喜欢哪几个? [图片] 国内秘塔AI搜索 https://metaso.cn/ 好用,免费,国内 Top 水平 天工AI (昆仑万维) https://www.tiangong.cn/ 好用,免费,技术实力 Top 且快速升级中 简单搜索 App (百度) https://secr.baidu.com/ 只有手机版,规规矩矩的一款AI增强搜索应用 360 AI 搜索 https://so.360.com 最近数据增长蛮快的,综合体验比较流畅 澜舟AI搜索 https://ai-search.langboat.com 中规中矩 BrainStorm …

来源:https://zhuanlan.zhihu.com/p/698345703

又一款爆火AI游戏诞生!《换你来当爹》做对了什么?| ShowMeAI体验报告

[图片] 社区里几百人玩一款AI游戏的场面,值得记录一下! 大模型游戏化极度看重〖有趣〗程度。可有趣的灵魂那么难得,以至于只要一眼,我们就在产品的海洋里发现了 ta 。1. 有趣的灵魂在发疯疯疯 《换你来当爹》是一款全员发疯的AI游戏,主线任务是任意设定一个角色,然后把他培养成「大孝子」!灵感估计来源于男生大学宿舍里互相喊「爸爸」的传统?看到设定的一瞬间,会心一笑 游戏最初在即刻平台出圈,随后传回微信社群,并成功激发起…

来源:https://zhuanlan.zhihu.com/p/697856247

朱啸虎:AI应用明年肯定大爆发;第3款爆火AI游戏出现了;AI应用定价策略「不能说的秘密」;人类数据不够用了怎么办 | ShowMeAI日报

日报&周刊合集 | 生产力工具与行业应用大全 | 点赞关注评论拜托啦!1. 换你来当爹:国内第3款爆火出圈的AI游戏应用,hhh 太搞笑了 [图片] 周末的时候,社群里伙伴们开始玩一款「 换你来当爹」的AI游戏 进入游戏界面后,输入名字,系统随机生成孩子的「出生设定」。 然后恭喜你!可以开始当爹了!! 好大儿的培养过程,伴随着各种糟心的意外,然后把难题摆在你面前。 哎呀呀!逆子… 这时,你可以在系统给定的两个选项中选择一个,当然也…

来源:https://zhuanlan.zhihu.com/p/697655366

上海交通大学《动手学大模型》编程实战课;提示工程大赛冠军经验分享;AI Agent最新行业地图(3份);人类与ChatGPT恋爱行为指南;提升AI产品留存率的7个技巧 | ShowMeAI日报

日报&周刊合集 | 生产力工具与行业应用大全 | 点赞关注评论拜托啦! 1. 终于来了!OpenAI 周一官网直播,ChatGPT 和 GPT-4 上新啦! [图片] Sam Altman 和 OpenAI 近期一直在造势,演讲、访谈、小更新等动作不断。终于!官方推特宣布,将于 美西时间5月13日上午10点 (⏰ 北京时间5月14日凌晨1点) 在 OpenAI 官网进行直播,演示 ChatGPT 和 GPT-4 的更新。 到底会更新什么呢?!!各方还在猜来猜去。@indigo 的猜测帖 传播度很广,精选…

来源:https://zhuanlan.zhihu.com/p/697448133

ShowMeAI | 全球最有前途的100家AI公司,中国2家上榜;混合专家模型MoE详解;人大最新《大语言模型》电子书开放下载;斯坦福最新AI指数报告

日报&周刊合集 | 生产力工具与行业应用大全 | 点赞关注评论拜托啦! 1. CB Insights 发布「AI 100 2024」榜单,评选出全球最有前途的 100 家人工智能公司 [图片] CB Insights 是全球知名的市场情报分析机构,以其深入的数据分析、前瞻性的行业洞察而著称。CB Insights 最近发布了「AI 100 2024 」榜单,综合考虑了公司交易活动、行业合作伙伴关系、团队实力、投资者实力、专利活动、专项评分等数据维度,并结合 CB Insights 调研和访谈,…

来源:https://zhuanlan.zhihu.com/p/696949266

Aminer.cn

训练数据匮乏:LLM在正式定理证明中的挑战

别担心,AMiner AI会帮助你高效检索和阅读文献!

来源:https://www.aminer.cn/research_report/665d2bd6c028d8419b08ba06

GPU内存瓶颈:大规模语言模型推理能力的制约因素

想把握最新的科技进展和研究成果,却发现自己的阅读速度根本赶不上文献产出的速度?

来源:https://www.aminer.cn/research_report/665555cec028d8419b0438c5

虚构事实的担忧:大型语言模型的新知识处理能力

AMiner AI,一款集发现论文、分析论文、理解论文、写作论文于一体的科研小助手。它会帮助你更加游刃有余地穿梭在学术海洋中,让科研变得更加有趣和高效!

来源:https://www.aminer.cn/research_report/664c3a53707801418e87e415

大型语言模型能否提高情感分析的准确性?

别担心,AMiner AI会帮助你高效检索和阅读文献!

来源:https://www.aminer.cn/research_report/66444165707801418e835757

清华团队提出“智能体医院”:医生智能体可实现自我进化|大模型周报

清华团队提出“智能体医院”:医生智能体可实现自我进化

来源:https://www.aminer.cn/research_report/6642cb8c707801418e827a76

arXiv.org

XAI4LLM. Let Machine Learning Models and LLMs Collaborate for Enhanced

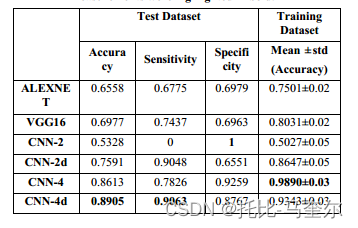

In-Context Learning in Healthcare The integration of Large Language Models (LLMs) into healthcare diagnostics offers a promising avenue for clinical decision-making. This study outlines the development of a novel method for zero-shot/few-shot in-context learning (ICL) by integrating medical domain knowledge using a multi-layered structured prompt. We also explore the efficacy of two communication styles between the user and LLMs: the Numerical Conversational (NC) style, which processes data incrementally, and the Natural Language Single-Turn (NL-ST) style, which employs long narrative prompts. Our study systematically evaluates the diagnostic accuracy and risk factors, including gender bias and false negative rates, using a dataset of 920 patient records in various few-shot scenarios. Results indicate that traditional clinical machine learning (ML) models generally outperform LLMs in zero-shot and few-shot settings. However, the performance gap narrows significantly when employing few-shot examples alongside effective explainable AI (XAI) methods as sources of domain knowledge. Moreover, with sufficient time and an increased number of examples, the conversational style (NC) nearly matches the performance of ML models. Most notably, LLMs demonstrate comparable or superior cost-sensitive accuracy relative to ML models. This research confirms that, with appropriate domain knowledge and tailored communication strategies, LLMs can significantly enhance diagnostic processes. The findings highlight the importance of optimizing the number of training examples and communication styles to improve accuracy and reduce biases in LLM applications.

来源:http://arxiv.org/abs/2405.06270v3

Human vs. Machine: Behavioral Differences Between Expert Humans and

Language Models in Wargame Simulations To some, the advent of artificial intelligence (AI) promises better decision-making and increased military effectiveness while reducing the influence of human error and emotions. However, there is still debate about how AI systems, especially large language models (LLMs), behave compared to humans in high-stakes military decision-making scenarios with the potential for increased risks towards escalation and unnecessary conflicts. To test this potential and scrutinize the use of LLMs for such purposes, we use a new wargame experiment with 107 national security experts designed to look at crisis escalation in a fictional US-China scenario and compare human players to LLM-simulated responses in separate simulations. Wargames have a long history in the development of military strategy and the response of nations to threats or attacks. Here, we show a considerable high-level agreement in the LLM and human responses and significant quantitative and qualitative differences in individual actions and strategic tendencies. These differences depend on intrinsic biases in LLMs regarding the appropriate level of violence following strategic instructions, the choice of LLM, and whether the LLMs are tasked to decide for a team of players directly or first to simulate dialog between players. When simulating the dialog, the discussions lack quality and maintain a farcical harmony. The LLM simulations cannot account for human player characteristics, showing no significant difference even for extreme traits, such as "pacifist" or "aggressive sociopath". Our results motivate policymakers to be cautious before granting autonomy or following AI-based strategy recommendations.

来源:http://arxiv.org/abs/2403.03407v2

Multiscale Causal Learning

Biological intelligence is more sample-efficient than artificial intelligence (AI), learning from fewer examples. Here we answer why. Given data, there can be many policies which seem "correct" because they perfectly fit the data. However, only one correct policy could have actually caused the data. Sample-efficiency requires a means of discerning which. Previous work showed sample efficiency is maximised by weak-policy-optimisation (WPO); preferring policies that more weakly constrain what is considered to be correct, given finite resources. Biology's sample-efficiency demonstrates it is better at WPO. To understand how, we formalise the "multiscale-competency-architecture" (MCA) observed in biological systems, as a sequence of nested "agentic-abstraction-layers". We show that WPO at low levels enables synthesis of weaker policies at high. We call this "multiscale-causal-learning", and argue this is how we might construct more scale-able, sample-efficient and reliable AI. Furthermore, a sufficiently weak policy at low levels is a precondition of collective policy at higher levels. The higher level "identity" of the collective is lost if lower levels use an insufficiently weak policy (e.g. cells may become isolated from the collective informational structure and revert to primitive behaviour). This has implications for biology, machine learning, AI-safety, and philosophy.

来源:http://arxiv.org/abs/2405.02325v2

Embedding Privacy in Computational Social Science and Artificial

Intelligence Research Privacy is a human right. It ensures that individuals are free to engage in discussions, participate in groups, and form relationships online or offline without fear of their data being inappropriately harvested, analyzed, or otherwise used to harm them. Preserving privacy has emerged as a critical factor in research, particularly in the computational social science (CSS), artificial intelligence (AI) and data science domains, given their reliance on individuals' data for novel insights. The increasing use of advanced computational models stands to exacerbate privacy concerns because, if inappropriately used, they can quickly infringe privacy rights and lead to adverse effects for individuals -- especially vulnerable groups -- and society. We have already witnessed a host of privacy issues emerge with the advent of large language models (LLMs), such as ChatGPT, which further demonstrate the importance of embedding privacy from the start. This article contributes to the field by discussing the role of privacy and the issues that researchers working in CSS, AI, data science and related domains are likely to face. It then presents several key considerations for researchers to ensure participant privacy is best preserved in their research design, data collection and use, analysis, and dissemination of research results.

来源:http://arxiv.org/abs/2404.11515v2

Fundamental Limitations of Alignment in Large Language Models

An important aspect in developing language models that interact with humans is aligning their behavior to be useful and unharmful for their human users. This is usually achieved by tuning the model in a way that enhances desired behaviors and inhibits undesired ones, a process referred to as alignment. In this paper, we propose a theoretical approach called Behavior Expectation Bounds (BEB) which allows us to formally investigate several inherent characteristics and limitations of alignment in large language models. Importantly, we prove that within the limits of this framework, for any behavior that has a finite probability of being exhibited by the model, there exist prompts that can trigger the model into outputting this behavior, with probability that increases with the length of the prompt. This implies that any alignment process that attenuates an undesired behavior but does not remove it altogether, is not safe against adversarial prompting attacks. Furthermore, our framework hints at the mechanism by which leading alignment approaches such as reinforcement learning from human feedback make the LLM prone to being prompted into the undesired behaviors. This theoretical result is being experimentally demonstrated in large scale by the so called contemporary "chatGPT jailbreaks", where adversarial users trick the LLM into breaking its alignment guardrails by triggering it into acting as a malicious persona. Our results expose fundamental limitations in alignment of LLMs and bring to the forefront the need to devise reliable mechanisms for ensuring AI safety.

来源:http://arxiv.org/abs/2304.11082v6

齐思

齐思头条2024/06/04「FineWeb-Edu数据集发布,Mamba-2模型性能提升,4-bit Shampoo内存高效训练,Firefox集成Transformers.js,Stable Diffusion 3 Medium发布」

Twitter:

高性能大型语言模型解释 :Thom Wolf详细介绍了创建高质量网络规模数据集的过程,如Llama3, GPT-4, 和 Mixtral ,并引入了在知识密集型基准测试中表现优异的FineWeb-Edu 数据集。阅读完整报告这里。

FineWeb技术报告发布 :Hugging Face发布了FineWeb技术报告 ,详细介绍了处理决策,并引入了FineWeb-Edu 数据集,这是一个经过高教育内容过滤的子集。该数据集旨在通过专注于高质量教育材料来改进LLM训练,详细信息请见tweets。

视频分析中的Video-MME基准 :Video-MME 是第一个用于视频分析的多模态大型语言模型(MLLMs)综合评估基准,其中Gemini 1.5 Pro 表现优于其他模型,包括GPT4o。更多详情请见项目公告。

Mamba-2模型 :Mamba-2模型 在困惑度和壁钟时间方面表现优于Mamba和Transformer++,利用了将Transformer视为结构化状态空间的概念,提供了对广义模型和高效算法的见解,详细信息请见这里。

Mamba-2:线性注意力变体和SSM中的状态空间对偶 :研究人员开发了一个理论框架,展示了许多线性注意力变体 和状态空间模型(SSMs) 的等价性,结果是Mamba-2 模型。Mamba-2在语言建模中表现优于其前身Mamba-1,并匹配强大的Transformer架构。更多详情请见tweet。

4-bit Shampoo用于内存高效的网络训练 :4-bit Shampoo 算法在测试准确性上与其32-bit版本相当,同时更具内存效率,详细信息请见新论文。

Firefox集成Transformers.js用于设备端功能 :Firefox 将使用Transformers.js 支持设备端功能,如在PDF编辑器中生成图像的替代文本和改进翻译,完全离线且开源。了解更多公告。

Stable Diffusion 3 "Medium"发布 :StabilityAI 发布了Stable Diffusion 3 的新版本“Medium”,并计划开源。此版本补充了现有的Large和X-Large版本。更多详情请见发布说明。

Stable Diffusion 3 Medium发布日期公布 :Stability AI宣布Stable Diffusion 3 Medium 将于6月12日 公开发布,感兴趣的用户可以在等待名单上注册以获取模型发布的更新。

大语言模型对编程和数据科学技能的影响 :大型语言模型(LLMs)显著提升了初学者和中级程序员及数据科学家 的技能水平,使其快速进阶到更高的专业水平。详细讨论请见这里。

ChatGPT的自定义指令可能降低准确性 :Sam Altman的ChatGPT自定义指令 可能通过短路其思维链过程来降低模型的准确性。Ethan Mollick详细解释了这一见解,认为AI的“思考”过程本质上与其写作过程相关,详细信息请见这里。

机器学习的智能辩论 :François Chollet认为当前的机器学习(ML)系统缺乏真正的智能 ,因为它们仅通过静态推理实现局部泛化,这被他比作“机器作弊”而非真正的智能。详细观点请见他的推特。

AI对企业软件的影响 :Aaron Levie讨论了AI在变革企业软件领域 方面的巨大潜力,强调了理解AI优势和应用的重要性。更多见解请见他的推特。

文本到图像模型的进展 :Google DeepMind推出了Imagen 3 ,这是他们最高质量的文本到图像模型,能够创建包括复杂元素如手和脸在内的逼真视觉效果。感兴趣的用户可以通过ImageFX加入等待名单。

Nvidia的收入来自微软 :报告显示,微软是Nvidia去年最大的客户 ,贡献了Nvidia收入的19%,这一信息由投资银行公司UBS强调。详细信息请见Dan Nystedt的推特。

稀疏最大更新参数化(SμPar)论文发布 :Cerebras Systems引入了稀疏最大更新参数化(SμPar) ,确保最佳超参数在不同宽度或稀疏度水平上保持一致,显著降低了超参数调整成本。此创新使SμPar实现了更优的损失,详细信息请见他们的论文。

Gradio的图像到3D模型开源 :Gradio宣布在Huggingface上发布开源的图像到3D模型 ,目前被认为是最好的模型之一。研究社区可以访问演示和检查点,更多详情请见这里。

WonderJourney:生成式AI用于3D场景创建 :WonderJourney是一种新的生成式AI工具,可以从单个图像或文本输入创建一长串多样但相连的3D场景。此创新项目在Koven_Yu的推特和arXiv论文中有详细介绍。

Cradle Health的可逆冷冻技术 :Cradle Health由Laura Deming和Hunter Cole Davis共同创立,正在开发类似于冬眠舱的可逆冷冻技术,用于长期太空旅行。公司已筹集4800万美元,并在先前冷冻保存的神经组织中实现了电活动,详细信息请见LauraDeming的推特。

FineWeb-Edu:一个1.3万亿标记的数据集 :FineWeb-Edu是一个包含1.3万亿标记的新数据集,在教育基准测试如MMLU、ARC和OpenBookQA上表现优于其他开放网络数据集。数据集及其技术报告可在LoubnaBenAllal1的推特中找到。

使用LangChain进行本地RAG与电子邮件 :LangChainAI引入了一种方法,使用Unstructured、Ollama和LangChain等工具在本地执行电子邮件的检索增强生成(RAG)。更多详情请见LangChainAI的推特。

NVIDIA在COMPUTEX 2024上推出Blackwell驱动的系统 :NVIDIA推出了最新的Blackwell驱动的系统 ,包括NVIDIA GB200 NVL2 ,旨在引领下一次工业革命。详细信息请见新闻稿。

GPT-4的1.8T MoE模型 :Nvidia的演示揭示了GPT-4 是一个1.8万亿参数的专家混合(MoE)模型 ,展示了AI模型扩展方面的显著进展,详细信息请见tweet。

使用LLMs训练Python脚本 :一个仓库展示了使用LLM 迭代改进从Gmail提取结构化数据的Python脚本,突出了与LlamaIndex的GMail读取工具 的集成。更多详情请见推特。

未来Web代理的网络研讨会 :由LlamaIndex 和MultiOn_AI 主办的网络研讨会将探讨能够执行从日程安排到在线支付任务的个性化Web代理的开发,API集成了LlamaHub 。加入讨论请见链接。

打破ML防御的最小努力 :Nicholas Carlini继续揭示在顶级安全会议上发表的ML防御 中的漏洞,通常只需最小的努力,如评估中的一行错误修复。此系列讨论在tweet中有详细介绍。

多语言聊天机器人竞技场更新 :Chatbot Arena 现在支持四种新语言,GPT-4o 在英语、德语和西班牙语中领先,而Gemini-1.5-Pro 在日语、中文和法语中表现出色。完整的排行榜和投票详情请见这里。

Nvidia的RAPIDS cuDF集成 :在COMPUTEX 2024 上,Nvidia的CEO展示了如何在Google Colab 上使用RAPIDS cuDF 使Pandas代码 速度提高50倍,且无需更改代码。更多信息请见tweet。

LoRA学习更少,遗忘更少 :论文“LoRA学习更少,遗忘更少”强调LoRA (低秩适应)在指令微调 方面比继续预训练更有效,显示出对学习率和目标模块选择的敏感性。它还展示了更强的正则化效果,比dropout和权重衰减更好地减少过拟合,并通过仅训练选定权重矩阵的低秩扰动来节省内存。详细发现和与全微调的比较请见原始推特。

长上下文模型在上下文学习中的作用 :一篇新论文探讨了长上下文模型 在上下文学习(ICL) 中的有效性,显示随着更多示例的增加,性能持续提高,通常超过使用LoRA微调的模型。研究强调了长上下文ICL的独特属性,如对示例顺序的敏感性降低。阅读完整分析这里。

bGPT:用于数字世界模拟的字节级Transformer :论文“超越语言模型:字节模型是数字世界模拟器”中介绍的bGPT 模型使用下一个字节预测来模拟数字世界,在文本、音频和图像等任务中表现与专用模型相当,并在转换符号音乐数据和模拟CPU行为等任务中表现出色。更多信息请见tweet。

Project G-Assist:Nvidia的上下文感知游戏AI :Nvidia的Project G-Assist 为游戏提供上下文感知的帮助和个性化响应,分析系统性能并提供实时指导。它通过建议策略、优化设置和动态降低GPU电压来增强游戏体验。公告详情请见tweet。

大语言模型的真实上下文能力 :Nvidia对长上下文语言模型 的研究表明,只有四个模型(GPT-4, Command-R, Yi-34B, 和 Mixtral)在32K标记长度下保持令人满意的性能。引入了RULER基准 来评估LLM处理长上下文信息的能力,重点是减少对参数知识的依赖的合成任务。见解请见tweet。

Llamanet:用llama.cpp替换OpenAI :Llamanet 允许开发者只需一行代码即可用llama.cpp 替换OpenAI,方便构建本地LLM应用程序而无需单独的LLM后端。此工具在tweet中介绍。

自定义指令可能降低ChatGPT的准确性 :Sam Altman的ChatGPT自定义指令 可能通过短路其思维链过程来降低模型的准确性。Ethan Mollick详细解释了这一见解,认为AI的“思考”过程本质上与其写作过程相关,详细信息请见这里。

Unix哲学与提示工程 :Nearcyan讨论了如何使用Unix哲学 有效地说明理想的提示工程和LLM链 。这种方法强调简洁性和模块化,这对于高效的AI模型训练和部署至关重要,详细信息请见推特。

HackerNews:

麦克斯韦方程组直观指南 链接: 这篇文章提供了麦克斯韦方程组的视觉和直观解释,旨在使复杂的电磁概念更易于理解。

讨论亮点:

-

视觉和直观的方法: 该指南因其美丽的图表 和直截了当的解释而受到赞誉,这些解释直击电磁学(E&M)所需的关键向量微积分概念的核心。

-

教育影响: 许多用户表示,这样的资源在他们自己的学习过程中将是无价的,建议未来几代人 可以从这种方法中受益匪浅。

-

与传统教材的比较: 该指南与传统教材如Jackson的《经典电动力学》 进行了对比,后者被认为在数学上具有挑战性且不太直观。该指南旨在通过提供更直观的理解 来填补这一空白。

-

工具和致谢: 作者感谢Grant Sanderson (3Blue1Brown) 和使用Vexlio 生成图表,强调了这些工具在创建指南中的重要性。

-

反馈和改进: 一些用户建议进行小幅改进,例如减少感叹号的使用以提高可读性,并通过额外的场景和考虑来澄清某些部分,特别是关于电场和磁场的统一 。

AMD发布Ryzen 9000桌面处理器,Zen 5在2024年Computex上成为焦点 链接: AMD的CEO苏姿丰博士宣布了Ryzen 9000系列,采用新的Zen 5微架构,承诺比Zen 4和Ryzen 7000系列有更大的进步,计划于2024年7月发布。讨论亮点:

-

AVX512性能:

-

“如果时钟速度能保持在接近5GHz的情况下,单周期的AVX512比双周期的要大得多。”

-

“L1缓存带宽的加倍很有趣!可能需要实际提供丰富的AVX512指令流。”

-

“Zen 5现在在所有重要指令中每时钟周期的AVX-512吞吐量与英特尔相匹配。”

-

-

推测执行攻击:

-

“在推测执行攻击方面,AMD的记录要好得多。”

-

-

PCIe 5.0通道分配:

-

“9950X的24x PCIe 5.0通道(约90GB/s)分配为:16x用于图形,1x用于M.2端口,7x连接到X870E芯片组。”

-

-

插槽和芯片组重用:

-

“这些处理器将使用现有的AM5插槽,因此它们基本上不能对通道数量和分配进行重大更改,只能提高每通道速度。”

-

-

性能和市场定位:

-

“Geekbench Ryzen 9 7950x的最高分是2930,所以如果我们慷慨地给9950x 15%的提升,我们将达到3380,这仍然比苹果芯片低400分左右。”

-

“Ryzen在1T性能上从未领先,但强调nT和核心数量。”

-

-

图形架构:

-

“这些CPU也使用上一代的图形架构,RDNA2。”

-

“这些是除了重度游戏之外的不错的GPU。我用它驱动两个4k屏幕,甚至对于一些轻度游戏(如Factorio)也完全没问题。”

-

-

市场策略:

-

“AMD似乎在这一代桌面处理器上采取了保守策略。同一节点,相似的频率,相同的核心数量,相同的IOD,X3D芯片只会在后期到来……IPC似乎是这里唯一值得注意的改进。”

-

Discord:

Mamba-2发布与状态空间对偶(SSD) :Albert Gu宣布了Mamba-2 的发布,具有8倍更大的状态和50%更快的训练速度。该框架引入了状态空间对偶(SSD) ,连接了SSM和线性注意力。

深度学习在序列建模中的局限性 :新论文讨论了深度学习模型(包括SSM和Transformer)在处理需要深层组合性和多步推理任务时的局限性,提供了理论框架和实证证据。

Prisma库用于多模态机制解释 :Prisma是一个基于TransformerLens的新库,支持视觉Transformer(ViTs)和视觉-文本模型如CLIP,提供logit归因、注意力头可视化和激活修补等工具。

视觉Transformer中的突现分割 :使用Emoji Logit Lens ,研究人员发现ViTs中的patch-level logit归因可以作为分割图,将图像patch分类为不同类别,而无需显式分割训练。这一突现特性也在CLIP模型中观察到。

VQVAE中的码本崩溃 :@josejhlee观察到在CIFAR10 的训练/测试集重建过程中,512个码本向量中只有55个被使用,表明存在码本崩溃 问题。

可微分Top-K选择 :@swiftlynx询问从张量中可微分选择K个向量的方法。@maugrim_建议使用sigmoid + topk与直通估计器,并参考了NeurIPS 2020论文。

ReAct代理在Langchain中的应用 :@warpwing正在探索在ReAct代理 中使用web搜索连接器来限定查询域。更多细节请参考ReAct代理文档。

代理选项在API SDK中的应用 :@lazydogp和@sssandra询问了在不同语言的API SDK中提供代理选项 的可用性,强调其对企业工作流的重要性。

Azure集成在企业中的应用 :@lennart_85311强调了Azure集成 在其企业工作流中的必要性,并表示如果不解决可能会转向Jina AI。@1vnzh确认正在努力在几周内发布此集成。

Aya 23模型实现 :@enzolutions赞扬Cohere的Aya 23模型 是第一个使用GGUF实现 在本地机器上运行的模型,已成功在Python和llama.cpp 中测试。@sssandra感谢Cohere 4 AI研究实验室 开发了Aya 23。

Anthropic的工具使用和函数调用 :@luispl77指出Anthropic 发布了官方工具和函数调用,允许Claude 与外部客户端工具和函数交互。详细文档请见此处。

Claude模型推荐 :对于复杂工具使用,推荐使用Claude 3 Opus ,因其能够处理多个工具并捕捉缺失参数。对于简单工具,建议使用Claude 3 Haiku ,因其默认更频繁地使用工具。

Mamba-2性能 :@swyxio分享了Mamba-2在困惑度和墙钟时间上优于Mamba 和Transformer++ 。论文链接。

STORM:通过检索和多视角问题提问生成主题大纲 :STORM使用互联网搜索生成类似维基百科的文章。系统包括预写(收集参考资料和生成大纲)和写作(使用大纲生成带有引用的全文)。文档和设置说明可供定制和本地执行。

状态空间对偶(SSD)框架 :论文"Transformers are SSMs: Generalized Models and Efficient Algorithms Through Structured State Space Duality"由Tri Dao和Albert Gu撰写,探讨了Transformer 和状态空间模型(SSM) 之间的理论联系。SSD框架 引入了如Mamba-2 的新架构,比以前的模型快2-8倍,并在语言建模中与Transformer竞争。

LaVi-Bridge用于文本到图像生成 :LaVi-Bridge集成了多种预训练语言模型和生成视觉模型,用于文本到图像生成。它使用LoRA和适配器 ,无需修改原始模型权重。支持的组合包括T5-Large + U-Net(SD) 和Llama-2 + U-Net(SD) 。技术细节和设置说明。

Perplexity AI的自定义提示和集合 :@paradroid讨论了在Perplexity AI中使用自定义提示和框架,特别是Scratchpad 框架用于链式思维推理。此框架在Claude 3模型 中效果显著,并可集成到ChatGPT和Perplexity AI的集合中。示例页面。

量子计算与虫洞 :研究人员使用Google的Sycamore量子处理器 模拟了一个虫洞,通过创建两个纠缠的黑洞并在它们之间传输信息,支持了全息原理,表明时空和引力可能源自量子效应。更多信息。

新的1024px模型 :@drhead提到一个新的1024px模型 ,具有更高的通道数自编码器,预计性能优于以前的f/8 1024模型。

模型性能指标 :@drhead指出新的2B模型 在多个指标上优于旧的8B模型。

SDXL 1.0训练 :@pseudoterminalx推测以前分配给8B模型的计算资源被重新分配给2B模型,导致性能提升。

AI4Health医疗创新挑战 :@nikhil2.0分享了AI4Health医疗创新挑战的细节,这是一个专注于AI解决方案的黑客松/创意大赛,提供超过$5k的奖品和工作坊。

量化和稀疏性在神经网络中的应用 :@chr0nomaton询问了在神经网络中量化和稀疏性的有效性和最低要求,以提高游戏引擎中自定义神经网络引擎的读取性能。@andreaskoepf解释说,如果有量化格式的硬件支持(如FP8张量核心 ),可以通过如16位到8位或8位到4位的减少实现显著加速,但需要考虑质量折衷。

STORM:通过检索和多视角问题提问生成主题大纲 :STORM使用互联网搜索生成类似维基百科的文章。系统包括预写(收集参考资料和生成大纲)和写作(使用大纲生成带有引用的全文)。文档和设置说明可供定制和本地执行。

状态空间对偶(SSD)框架 :论文"Transformers are SSMs: Generalized Models and Efficient Algorithms Through Structured State Space Duality"由Tri Dao和Albert Gu撰写,探讨了Transformer 和状态空间模型(SSM) 之间的理论联系。SSD框架 引入了如Mamba-2 的新架构,比以前的模型快2-8倍,并在语言建模中与Transformer竞争。

LaVi-Bridge用于文本到图像生成 :LaVi-Bridge集成了多种预训练语言模型和生成视觉模型,用于文本到图像生成。它使用LoRA和适配器 ,无需修改原始模型权重。支持的组合包括T5-Large + U-Net(SD) 和Llama-2 + U-Net(SD) 。技术细节和设置说明。

Perplexity AI的自定义提示和集合 :@paradroid讨论了在Perplexity AI中使用自定义提示和框架,特别是Scratchpad 框架用于链式思维推理。此框架在Claude 3模型 中效果显著,并可集成到ChatGPT和Perplexity AI的集合中。示例页面。

量子计算与虫洞 :研究人员使用Google的Sycamore量子处理器 模拟了一个虫洞,通过创建两个纠缠的黑洞并在它们之间传输信息,支持了全息原理,表明时空和引力可能源自量子效应。更多信息。

新的1024px模型 :@drhead提到一个新的1024px模型 ,具有更高的通道数自编码器,预计性能优于以前的f/8 1024模型。

模型性能指标 :@drhead指出新的2B模型 在多个指标上优于旧的8B模型。

SDXL 1.0训练 :@pseudoterminalx推测以前分配给8B模型的计算资源被重新分配给2B模型,导致性能提升。

AI4Health医疗创新挑战 :@nikhil2.0分享了AI4Health医疗创新挑战的细节,这是一个专注于AI解决方案的黑客松/创意大赛,提供超过$5k的奖品和工作坊。

量化和稀疏性在神经网络中的应用 :@chr0nomaton询问了在神经网络中量化和稀疏性的有效性和最低要求,以提高游戏引擎中自定义神经网络引擎的读取性能。@andreaskoepf解释说,如果有量化格式的硬件支持(如FP8张量核心 ),可以通过如16位到8位或8位到4位的减少实现显著加速,但需要考虑质量折衷。

HuggingFace & Github:

游戏与自动化

-

GitHub用户shamhi的“HamsterKombatBot” 是一个专门设计用于自动化在游戏HamsterKombat中挖掘硬币的机器人 。该机器人 具备多线程 、代理绑定 、自动购买物品 、随机点击 等高级功能。通过设置API_ID和API_HASH等参数,可以自定义机器人的行为,适用于Windows和Linux 系统。

信息安全与漏洞利用

-

GitHub用户amalmurali47的git_rce 提供了一个概念验证(PoC) ,用于利用CVE-2024-32002 漏洞。此漏洞允许在git clone 操作期间进行远程代码执行(RCE) 。攻击者可以通过创建带有子模块的存储库,利用大小写不敏感 的文件系统中的符号链接处理来写入.git/目录,从而执行恶意钩子。此PoC适用于Windows和Mac 系统。详细的漏洞逆向解释可以在博客文章中找到,存储库包含用于创建PoC的脚本和在GitHub存储库上设置PoC的说明。

来源:https://news.miracleplus.com/share_link/28917

I-LLM:首次实现了LLM全整形量化,精度逼近浮点,超过Smooth/Omini/AffineQuant

这篇文章介绍了I-LLM,一种针对大型语言模型(LLMs)的整数量化方法,实现了接近浮点精度,超越了当前的Smooth、Omini和Affine Quant等最先进方法。这一突破意义重大,通过在推断过程中消除对浮点运算的需求,使得LLM能够高效部署在边缘和云设备上,而这些运算在计算上是昂贵的,且并非所有硬件都支持。I-LLM框架通过引入全平滑块重构(FSBR)和动态整数矩阵乘法(DI-MatMul)等技术,解决了通道和标记之间激活值波动较大的挑战。此外,它提供了使用高效位移计算非线性运算符的新颖解决方案,保持精度的同时使用整数运算。这项工作是侯谟人工智能、南京大学和东南大学的合作成果,是首次成功在LLMs上实现整数量化,有望使模型在低位宽硬件上运行时减少精度损失。如果您对LLM量化和部署的最新进展感兴趣,这篇内容值得一读。

来源:https://zhuanlan.zhihu.com/p/701393483

Caju AI在种子轮融资中筹集了300万美元 | SaaS新闻

Caju AI,一家专注于AI驱动客户参与解决方案的公司,成功在种子轮融资中获得了300万美元。这一投资由Grotech Ventures和Felton Group领导,还有其他天使投资者参与,旨在推动公司的增长和创新努力。Caju AI的平台以其分析各种渠道上的客户沟通能力脱颖而出,提供先进的分析和可操作的见解。这一融资事件具有重要意义,反映了投资者对生成式AI在客户参与领域的潜力的信心,尽管人们普遍怀疑AI初创公司对流行词的依赖以及区分和留存的挑战。对于那些对AI驱动的商业解决方案的不断发展以及该领域新兴参与者的战略举措感兴趣的人来说,Caju AI的这一进展值得关注。

来源:https://www.thesaasnews.com/news/caju-ai-closes-3-million-in-seed-round

Karpathy点赞,这份报告教你如何用 LLaMa 3创建高质量网络数据集

这份指南深入探讨了FineWeb-Edu的创建过程,这是一个专为高级语言模型如LLaMa 3的预训练而设计的高质量数据集。它通过利用LLaMa 3的力量,从庞大的15万亿标记的FineWeb数据集中过滤出了1.3万亿个优质标记。这份报告的重要性在于详细解释了教育内容如何增强语言模型的学习过程,因为它比一般互联网数据更加专注和相关。该数据集的性能值得关注,因为它在教育基准测试中胜过其他公共数据集,并且需要的标记数量明显较少以达到可比较的结果。这份内容对于人工智能和机器学习领域的研究人员和从业者尤为重要,展示了利用在LLM标记上训练的分类器进行大规模数据过滤的有效性。如果您对语言模型预训练的数据集创建细节以及高质量、领域特定数据对模型性能的影响感兴趣,这份报告值得一读。

来源:https://mp.weixin.qq.com/s/luZGMG1RRUT4X_ckt8hsCQ

D-CPT定律:大型语言模型的特定域连续预训练缩放定律

这篇名为"D-CPT Law: Domain-specific Continual Pre-Training Scaling Law for Large Language Models"的论文介绍了一种优化大型语言模型(LLMs)针对特定领域训练的新方法。由麻省理工学院的何浩然领导的团队撰写,这项研究解决了在预训练阶段确定通用数据和领域特定数据之间理想平衡的挑战。作者提出了D-CPT Law,旨在通过最小的训练成本预测LLMs在不同混合比、模型大小和数据集大小下的性能。值得注意的是,该论文将这一概念扩展到跨领域设置中的Cross-Domain D-CPT Law,大大减少了新领域所需的训练资源。这项工作突出之处在于提供了一种绕过寻找最佳混合比的资源密集型过程的方法,这在该领域是一种常见做法。这项研究的影响巨大,有可能导致针对特定领域(如法律或医学文本)更高效、更有效的LLMs训练。对于那些对培训特定领域LLMs的前沿方法感兴趣的人来说,这篇论文可能提供有价值的见解和实用解决方案。

来源:http://arxiv.org/abs/2406.01375v1

小互

TimeUi:简化ComfyUI 动画编辑的时间线节点系统

TimeUi:简化ComfyUI 动画编辑的时间线节点系统

来源:https://xiaohu.ai/p/9049

Backseat AI:英雄联盟 AI 游戏伴侣 通过语音为玩家提供实时的游戏评论和建议

Backseat AI:英雄联盟 AI 游戏伴侣 通过语音为玩家提供实时的游戏评论和建议

来源:https://xiaohu.ai/p/9039

100 个 Midjourney 随机风格参考 Sref Codes库 以及Sref Codes教程

100 个 Midjourney 随机风格参考 Sref Codes库 以及Sref Codes教程

来源:https://xiaohu.ai/p/9008

教程:如何把自己变成吉卜力电影角色 替换动画片中人物角色

教程:如何把自己变成吉卜力电影角色 替换动画片中人物角色

来源:https://xiaohu.ai/p/8989

Video-MME: 首个多模态大模型视频分析综合评估基准

Video-MME: 首个多模态大模型视频分析综合评估基准

来源:https://xiaohu.ai/p/8976

宝玉

NVIDIA 公布了到 2027 年的 GPU 和互连路线图 [译]

在计算、网络和图形的发展历史上,Nvidia 有许多独特之处。此刻,它拥有大量资金,并且凭借其架构、工程和供应链在生成式 AI (generative AI) 市场中占据了领先地位,使其能够随心所欲地制定任何可能带来进展的路线图。

来源:https://baoyu.io/translations/nvidia/nvidia-unfolds-gpu-interconnect-roadmaps-out-to-2027

使用大语言模型 (LLMs) 构建产品一年后的经验总结 (第二部分)[译]

运营大语言模型应用程序提出了一些在运营传统软件系统时熟悉的问题,但通常有新的变化来保持新鲜感。大语言模型应用程序还提出了全新的问题。我们将这些问题及其答案分为四部分:数据、模型、产品和团队。

来源:https://baoyu.io/translations/llm/what-we-learned-from-a-year-of-building-with-llms-part-ii

为什么对于有的人来说 ChatGPT 并没有什么卵用?

看到微博上一位医生这条被 ChatGPT-4o 坑的微博,尝试从技术角度解读一下,这样也许能更好的理解现阶段大语言模型的优缺点,在实际应用中能扬长避短。

来源:https://baoyu.io/blog/ai/why-do-someone-think-chatgpt-doesnot-really-work-for-them

使用大语言模型 (LLMs) 构建产品一年后的经验总结 (第一部分) [译]

现在是使用大语言模型 (LLMs) 构建产品的激动人心的时刻。在过去的一年中,LLMs 的表现已经“足够好”可以应用于现实世界。LLMs 改进的速度,加上社交媒体上的大量演示,将推动预计到 2025 年 AI 投资达到 2000 亿美元。LLMs 的广泛可用性,让每个人,而不仅仅是机器学习工程师和科学家,都能在他们的产品中构建智能。虽然构建 AI 产品的门槛已经降低,但要创建那些不仅仅是演示效果好的产品,仍然充满挑战。

来源:https://baoyu.io/translations/llm/what-we-learned-from-a-year-of-building-with-llms-part-1

谷歌搜索秘籍泄漏:揭秘内部工程文档 [译]

探索你一直渴望了解的谷歌算法的秘密。

来源:https://baoyu.io/translations/seo/secrets-from-the-algorithm-google-searchs-internal-engineering-documentation-has-leaked

Github

Codium-ai/cover-agent

CodiumAI Cover-Agent: An AI-Powered Tool for Automated Test Generation and Code Coverage Enhancement! 💻🤖🧪🐞

来源:https://github.com/Codium-ai/cover-agent

kyegomez/AlphaFold3

Implementation of Alpha Fold 3 from the paper: "Accurate structure prediction of biomolecular interactions with AlphaFold3" in PyTorch

来源:https://github.com/kyegomez/AlphaFold3

6677-ai/tap4-ai-webui

One-click to deploy your own ai tools directory with the open source web-ui

来源:https://github.com/6677-ai/tap4-ai-webui

Bklieger/groqbook

Groqbook: Generate entire books in seconds using Groq and Llama3

来源:https://github.com/Bklieger/groqbook

fofr/cog-consistent-character

Create images of a given character in different poses

来源:https://github.com/fofr/cog-consistent-character

本文档由扣子生成,资讯版权属于原作者。 豆包机器人链接:https://www.coze.cn/store/bot/7343089859382444051?bot_id=true 一支烟花社区提供技术支持,了解更多点击:https://t.zsxq.com/r8NOO 联系开发者微信反馈问题:play-with-ai